'En 2016, el meta-investigador John Ioannidis y sus colegas publicaron un artículo analizando 385,000 estudios y los resúmenes de más de 1.6 millones de documentos. Sus hallazgos muestran que el uso del p-value ha estado aumentando dentro de la investigación. El noventa y seis por ciento de los estudios analizados informaron un p-value significativo (menos de 0.05) en el resumen. Sin embargo, solo el diez por ciento de los estudios revisados informaron tamaños de efecto (una medida de la fuerza de una relación entre dos variables) e intervalos de confianza (una medida de incertidumbre). Sin este contexto, los p-values pueden ser engañosos. Esto es preocupante porque los medicamentos y los dispositivos médicos se justifican en base a la significancia estadística de sus p-values. Es sorprendentemente difícil encontrar una definición clara de un p-value. La American Statistical Association recientemente ofreció lo siguiente: "Informalmente, un p-value es la probabilidad bajo un modelo estadístico especificado de que un resumen estadístico de los datos (por ejemplo, la diferencia media de la muestra entre dos grupos comparados) sería igual o más extremo que su valor observado." Los investigadores utilizan p-values para ayudar a determinar si las diferencias entre los grupos de prueba son significativas o no. Primero, definen una hipótesis nula, que predice que no habrá diferencia entre los grupos. A continuación, el investigador calcula un p-value utilizando su conjunto de datos. Finalmente, se calcula un p-value, que indica la probabilidad de los resultados observados suponiendo que la hipótesis nula es verdadera. Un valor inferior a 0.05 generalmente se interpreta como que la hipótesis nula puede ser rechazada. Sin embargo, esto no le dice al investigador nada sobre si el medicamento funcionó o no. El problema con los p-values es que a menudo se usan para decidir si un estudio debe publicarse en una revista. Una buena investigación podría ser rechazada debido a un alto p-value. Esto puede alentar a los investigadores a manipular el sistema o informar selectivamente resultados con un pequeño p-value. Esta práctica no ética se llama p-hacking. Ron Wasserstein de la American Statistical Association teoriza que el uso de p-values se ha generalizado porque simplifican un proceso complejo de toma de decisiones en un solo número. Wasserstein también señala que los p-values son fáciles de calcular en la era moderna debido al software. El p-value se está utilizando para un propósito para el cual nunca se pretendió, según lo informado por Regina Nuzzo. El estadístico británico Ronald Fisher inventó los p-values en la década de 1920 para acelerar el proceso de determinar si un resultado merecía un examen más detenido. Se suponía que debía ser parte de un proceso más grande que "mezclaba datos y conocimientos previos para llegar a conclusiones científicas." Los p-values nunca se pretendió que fueran la última palabra sobre la significancia. En 2016, la American Statistical Association actualizó sus pautas sobre p-values: Los p-values pueden indicar cuán incompatibles son los datos con un modelo estadístico especificado. Los p-values no miden la probabilidad de que la hipótesis estudiada sea verdadera, o la probabilidad de que los datos fueran producidos por casualidad pura. Las conclusiones científicas y las decisiones empresariales o de políticas no deben basarse solo en si un p-value pasa un umbral específico. La inferencia apropiada requiere un informe completo y transparencia. Un p-value, o significancia estadística, no mide el tamaño de un efecto o la importancia de un resultado. Por sí mismo, un p-value no proporciona una buena medida de la evidencia con respecto a un modelo o hipótesis. A pesar de su crítica, Ioannidis no cree que los p-values deban ser desterrados de la ciencia. En cambio, las revistas deberían insistir en más información sobre "el tamaño del efecto, la incertidumbre en torno al tamaño del efecto y cuán probable [los resultados son] para ser verdad".'

'Muchos científicos utilizan una herramienta de medición para decidir si los resultados de su experimento son notables. Esta herramienta se llama p-value y fue inventada en la década de 1920. Pero algunos investigadores están denunciando un uso excesivo del p-value. Creen que en realidad podría estar perjudicando a la ciencia. Un estudio de 2016 muestra que los p-value se utilizan con mayor frecuencia en la investigación. Esto podría llevar a resultados potencialmente confusos, engañosos o incluso falsos en los experimentos científicos. Los medicamentos o la tecnología médica podrían pasar la inspección en base a sus "buenos" p-values, incluso si en realidad no funcionan muy bien. Los investigadores suelen usar los p-values para ver si hay una diferencia entre dos grupos. Por ejemplo, un grupo que tomó un medicamento para bajar el colesterol y otro que no. El investigador quiere saber si alguna diferencia en los grupos fue causada por el medicamento o algún factor desconocido. Usan un p-value para decidir si hay una diferencia real o no. Para calcular un p-value, se introduce en una calculadora una gran cantidad de datos sobre el estudio (como el número de personas involucradas y el cambio promedio en sus niveles de colesterol). El p-value no puede decir directamente a los investigadores si el medicamento está funcionando o no, pero puede ayudarles a entender si los datos del estudio son inesperados. Si el p-value es muy bajo (menor a 0.05), significa que sería poco probable obtener esos resultados por accidente. Pero no puede decir nada sobre por qué hubo una diferencia entre los grupos. Los científicos tienen varias preocupaciones sobre los p-values. Algunos científicos usan trucos para hacer que sus p-values se vean mejor para que sus estudios puedan ser publicados. También existe la preocupación de que buenos estudios no estén siendo publicados porque sus p-values no son lo suficientemente bajos. Los p-values son realmente comunes hoy en día porque son muy fáciles de calcular con una computadora y facilitan la decisión de qué investigación es importante. Pero esto es un error. Incluso Ronald Fisher, el inventor de los p-values, advirtió que no se deberían utilizar de esta manera. En lugar de eso, los investigadores deberían combinar sus datos con lo que ya saben sobre el mundo. La American Statistical Association compartió recientemente consejos sobre cómo se deben usar los p-values: Los p-values solo nos dicen cuán probable es un dato si el experimento no tiene ningún efecto. Los p-values no miden si una explicación de un efecto es verdadera o no. Las decisiones en ciencia, negocios y política no deberían basarse en p-values. Una buena investigación requiere informar todos los resultados honestamente. Los p-values no miden el tamaño de un efecto ni la importancia de un resultado. Un p-value por sí solo no puede decir si el experimento de un científico ha funcionado o no. Incluso los mayores críticos de los p-values no quieren deshacerse por completo de la herramienta. En cambio, los científicos necesitan hablar más sobre el tamaño de los efectos, lo que se desconoce sobre un experimento y cuán probable es que la investigación sea verdadera.'

'Los investigadores utilizan una herramienta de medición llamada p-value para demostrar que su investigación es significativa. El problema con los p-values es que muchas personas piensan que un p-value significativo prueba una hipótesis, pero eso no es cierto. Hay más factores en juego, pero los científicos están recurriendo cada vez más a los p-values para demostrar que su investigación es válida. Los científicos que dependen demasiado de los p-values podrían terminar con resultados de estudios engañosos. Existe el temor de que los medicamentos y los tratamientos médicos podrían ser promovidos y vendidos si sus p-values son "buenos", incluso si los productos no funcionan bien. El artículo explica que los p-values se utilizan cuando un investigador está tratando de averiguar si existe una diferencia entre dos grupos que están siendo estudiados. Por ejemplo, para averiguar si un medicamento baja el colesterol, tienen que descubrir si un grupo de personas que tomó el medicamento es diferente de otro grupo que no tomó el medicamento. Las estadísticas no pueden decirle a un investigador si alguna diferencia entre los grupos fue causada por el medicamento u otros factores desconocidos. Los p-values ayudan a determinar si la diferencia estadística entre los grupos fue probable o no. Aquí es cómo funciona: El investigador define una "hipótesis nula", que predice que la medicina no afecta el colesterol en absoluto. Luego se calcula el p-value a partir de los datos que recogiste. Incluye información como cuántas personas se probaron y los cambios promedio en el colesterol. El p-value resultante es un número entre 0 y 1. Un p-value bajo indica que es poco probable que la diferencia observada haya ocurrido de manera aleatoria. Si el p-value es menor a 0.05, muchos científicos consideran el resultado "estadísticamente significativo", indicando que el medicamento probablemente está haciendo una diferencia. Sin embargo, el p-value no puede decirte si el medicamento funciona o no. Sólo te permite conocer las probabilidades de ver estos datos si el medicamento no tuviera ningún efecto. La gente está preocupada de que las revistas solo publiquen estudios con un p-value por debajo de 0.05. Esto significa que a veces ignoran la investigación importante que no tiene un p-value suficientemente bajo. Lo peor es que los investigadores podrían manipular sus datos para obtener p-values bajos, sólo para ser publicados. Esto se llama "p-hacking". Los p-values están en todas partes porque son fáciles de calcular con una computadora y hacen que sea simple decidir si un hallazgo de investigación es significativo o no. Pero Ronald Fisher, el inventor de los p-values, advirtió que no deberían utilizarse de esta manera. En lugar de eso, los investigadores deberían combinar sus datos con lo que ya saben sobre el mundo y tomar decisiones basadas en un proceso más fluido. La American Statistical Association recientemente compartió consejos sobre cómo se deben usar los p-values: Los p-values solo nos dicen cuán probable son los datos si el experimento no tiene ningún efecto (la hipótesis nula es verdadera). Los p-values no miden si una hipótesis es verdadera o no. Las decisiones en ciencia, negocios y política no deberían basarse en p-values. Una buena investigación requiere informar todos los resultados de manera honesta. Los p-values no miden el tamaño de un efecto ni la importancia de un resultado. Un p-value por sí solo no es una buena evidencia a favor de una hipótesis o explicación. A pesar de las críticas, este artículo no dice que los p-values deberían ser eliminados. En cambio, los científicos necesitan hablar más sobre el tamaño de los efectos, lo que se desconoce acerca de un experimento y cuán probable es que la investigación sea verdadera. Educación en casa: Título: Entendiendo el Rol de los P-values en los Estudios Científicos Descripción del Curso: Este currículo de educación en casa está diseñado para ayudar a los padres a educar a sus hijos sobre la comprensión e interpretación de los p-values, su importancia en la investigación científica, y los problemas presentados por la dependencia excesiva en los p-values en la ciencia. Esquema del Curso: 1. Definiciones y Fundamentos: - ¿Qué es un p-value? - Una introducción a la Prueba de Hipótesis - Comprender la Significancia Estadística 2. El papel de los P-values en los Estudios Científicos: - Estudios de caso sobre el Uso de P-values en la Investigación Biomédica - Comprender la Significancia Estadística en los Estudios Científicos - Interpretar P-values en Estudios Publicados 3. Limitaciones y mal uso de los P-values: - Problemas con la Dependencia Excesiva en los P-values - Cómo los P-values pueden ser Engañosos - P-value: una medida de Significancia Estadística, no de Importancia Científica 4. Avanzando más allá de los P-values: - Introducción a los Tamaños de Efecto y a los Intervalos de Confianza - Importancia de Dar Contexto a los Hallazgos de los P-values 5. P-values en la Aplicación Práctica: - Trabajar a través de ejemplos de pruebas de hipótesis en biomedicina - Analizar e interpretar P-values de estudios biomédicos Métodos de Enseñanza del Curso: - Enseñanza estilo conferencia - Videos en línea - Cuestionarios interactivos - Sesiones de resolución de problemas - Discusiones en grupo - Tareas prácticas manuales Al final de este curso, los estudiantes comprenderán el papel de los p-values en la investigación científica, reconocerán sus limitaciones, y adquirirán la habilidad para evaluar críticamente su uso en la literatura científica. Se proporcionan a los padres amplios recursos que hacen que la enseñanza de este concepto en casa sea efectiva y atractiva. Título: Entendiendo las Pruebas de Hipótesis y el P-Value: Una Guía de Educación en Casa para Padres Objetivo: Equipar a los padres con suficiente conocimiento.''y herramientas para enseñar a sus hijos sobre las pruebas de hipótesis y p-value de una manera simplificada. Resultados del curso: Al final del curso, el alumno debería ser capaz de; - Comprender el concepto de la hipótesis nula en las pruebas de hipótesis. - Familiarizarse con el proceso de generación de un p-value. - Calcular p-value de forma independiente utilizando los datos proporcionados. - Comprender la interpretación de p-values en relación con la hipótesis nula. Desglose del curso: Lección 1: Introducción a las Pruebas de Hipótesis - Definir el concepto de prueba de hipótesis. - Explicar la importancia de las pruebas de hipótesis en la investigación científica. Lección 2: Entender la Hipótesis Nula - Definir la hipótesis nula. - Discutir ejemplos de la hipótesis nula en diferentes escenarios. Lección 3: Introducción al P-value - Definir p-value y su papel en el apoyo o rechazo de la hipótesis nula. - Discutir ejemplos de cálculos de p-value en diferentes situaciones. Lección 4: Cómo Calcular P-values - Discutir los datos necesarios para calcular un p-value. - Enseñar el método de ingresar números en una calculadora para obtener un p-value. - Actividad de práctica: Calcular p-values usando datos proporcionados. Lección 5: Interpretando el P-value - Discutir lo que indican los p-values bajos y altos con respecto a la hipótesis nula. - Discutir por qué un p-value de menos de 0.05 se considera estadísticamente significativo en la comunidad médica. - Discutir las limitaciones de los p-values en la determinación de la verdad o falsedad de la hipótesis original. Lección 6: P-values en la Publicación de Investigación - Discutir el papel de los p-values en la determinación de la publicabilidad de la investigación. - Discutir los posibles impactos negativos de la dependencia excesiva de los p-values en la validez de la investigación, como el "p-value hacking". Conclusión: Uso Responsable de P-values - Discutir la orientación publicada por la American Statistical Association sobre el uso más preciso y conservador del p-value. Materiales necesarios: Acceso a Internet, calculadoras, datos de muestra para el ejercicio. Lecturas adicionales: 1. "Una visión general de la hipótesis nula y p-value en las pruebas de hipótesis" por Ronald Fisher. 2. "Scientific Method and Statistical Errors" por Regina Nuzzo. Publicado por Nature. Plan de estudios para el hogar: Estadísticas prácticas para padres profesores Semana 1: - Definición de colesterol y su importancia en el cuerpo - Niveles de colesterol y su impacto en la salud humana Ejercicios: - Investigación sobre diferentes alimentos que pueden aumentar y disminuir el colesterol. Semanas 2 & 3: - Introducción a los experimentos: Grupo A (con medicina) vs Grupo B (sin medicina) - Entendiendo qué variables y otros factores están en los experimentos: Medicina y Colesterol Ejercicios: - Descubra ejemplos de la vida real de experimentos con dos grupos que difieren en una o varias variables. Semanas 4 & 5: - Entendiendo p-value: Introducción, Importancia y su cálculo - Introduciendo la Hipótesis Nula: la suposición para la hipótesis y su papel en el cálculo de p-value - Entendiendo el término "Estadísticamente Significativo" y su relevancia en la comunidad médica Ejercicio: - Práctica de cálculos de p-value con números y datos dados, entendiendo lo que es estadísticamente significativo Semanas 6-8: - Entendiendo las limitaciones de p-value: lo que puede y no puede decirnos - Analizando críticamente el concepto de p-value: discutiendo el artículo de Ioannidis sobre la crisis de p-value Ejercicios: - Leer y entender el artículo de Ioannidis. Responder con pensamientos y análisis individuales. Semanas 9-10: - Concepto de "P-dolatory o el "culto a la falsa significancia" - Entendiendo cómo se usan o se abusan los p-values en las publicaciones de investigación - Discutir sobre "p-value hacking" Discusión: - Discusión sobre la declaración de abuso de p-value por Ron Wasserstein, el director ejecutivo de la American Statistical Association. Semanas 11 & 12: - Reflexionando sobre el papel de la tecnología en los cálculos de p-value - Entendiendo la dependencia en p-value para determinar el valor de la investigación Ejercicio: - Discuta casos de la vida real donde p-value fue muy dependiente en la investigación. Debate sobre si esta dependencia está justificada. A lo largo de este curso, haremos uso de ejemplos de la vida real, participaremos en discusiones de pensamiento crítico y proporcionaremos ejercicios prácticos para entender los métodos estadísticos y su importancia en el mundo de la ciencia y la medicina.'

Let's start with the truth!

Support the Broken Science Initiative.

Subscribe today →

recent posts

And more evidence that victory isn’t defined by survival or quality of life

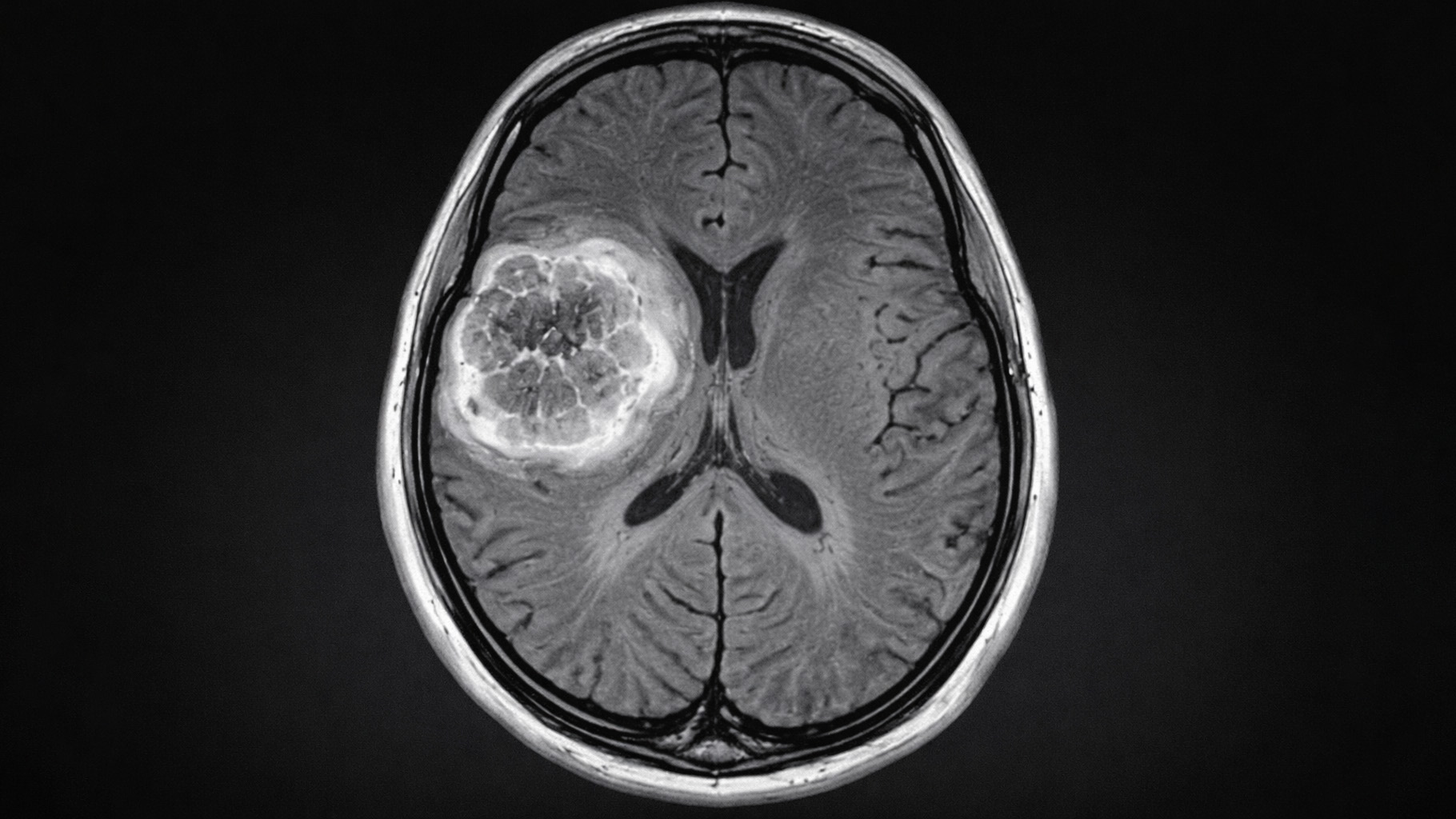

The brain is built on fat—so why are we afraid to eat it?

Q&A session with MetFix Head of Education Pete Shaw and Academy staff Karl Steadman