Choose a reading level from the dropdown above.

' Le document de Gerd Gigerenzer critique le manque d'attention porté aux tailles d'effet et l'accent excessif mis sur les tests d'hypothèse nulle dans la recherche. Malgré les recommandations de l'American Psychological Association, les tailles d'effet sont rarement signalées, entravant le calcul de la puissance statistique dans les tests. Il met en évidence une étude de 1962 de Jacob Cohen, qui a révélé que les expériences publiées dans une revue de psychologie majeure n'avaient qu'une chance de 50% de détecter un effet de taille moyenne, mais cela n'a pas affecté les attitudes des chercheurs envers les tailles d'effet. En fait, 24 ans plus tard, un pourcentage encore plus petit d'articles dans la même revue mentionnaient la puissance statistique. Ce document aborde également l'affirmation de Richard Feynman selon laquelle les tests d'hypothèse nulle sont dénués de sens sans hypothèses alternatives prédéfinies et condamne la pratique de 'overfitting' ou l'exploration rétrospective de données pour des résultats significatifs. La pratique courante d'adaptation des modèles aux données rend les tests d'hypothèse ultérieurs discutables. Overfitting, le terme utilisé pour décrire cette pratique d'utilisation de données connues pour adapter un modèle dans l'espoir de produire certains résultats, peut entraîner des variances expliquées impressionnantes, mais néglige la quantité de bruit et implique rarement des tests et la validation d'un modèle sur de nouvelles données. Les régressions linéaires multiples sont décrites comme une application ritualiste de la statistique et le document suggère que les heuristiques simples (comme tester un modèle sur de nouvelles données) peuvent parfois donner des résultats plus précis. L'auteur compare la prévalence des tests d'hypothèse nulle aux rituels sociaux, affirmant que cette mentalité ritualiste étouffe la pensée critique sur le processus de recherche. Le document conclut en soulignant que les chercheurs doivent éviter une adhésion aveugle aux rituels statistiques et sélectionner soigneusement une procédure statistique appropriée à partir de la "boîte à outils". Cela implique de porter une attention appropriée aux tailles d'effet, de prédéfinir les hypothèses alternatives, d'éviter le overfitting et de s'éloigner de la dépendance obstinée aux tests d'hypothèse nulle. Gigerenzer soutient que la théorie statistique doit être considérée comme un ensemble d'outils à appliquer de manière intelligente et judicieuse. Il suggère que l'analyse des données descriptives est souvent plus utile que les procédures statistiques décisives. Défier le statu quo dans la recherche académique favorisera l'émergence de la pensée statistique.'

'"Cet article, écrit par Gerd Gigerenzer, parle des problèmes de la façon dont nous utilisons les nombres et les données dans la science. Il explique que de nombreux chercheurs ne se concentrent pas suffisamment sur ce qui importe vraiment, la taille de l'effet et la puissance de leurs expériences. L'American Psychological Association dit que les chercheurs devraient toujours parler de la taille de l'effet et de la puissance statistique, mais ils ne le font souvent pas. Sans ces informations, il est difficile de savoir si un résultat est réellement important. Il y a longtemps, en 1962, une étude a constaté qu'il n'y avait qu'une chance sur deux pour que les chercheurs remarquent un changement de taille moyenne dans une expérience de psychologie. Même si beaucoup de chercheurs connaissent ce problème, ils continuent à faire les mêmes procédures statistiques sans réfléchir. Un scientifique célèbre du nom de Richard Feynman n'aimait pas la façon dont nous faisons souvent les expériences scientifiques. Il a dit que ce n'est pas parce que nous trouvons quelque chose d'intéressant que cela signifie beaucoup si nous ne pouvons l'expliquer qu'après qu'il se soit déjà produit. Nous devons d'abord prédire, puis voir si nous le trouvons. L'article met également en garde contre le 'surajustement'. Cela se produit lorsque nous espérons trouver des choses importantes dans nos données, puis commençons à inventer des histoires pour expliquer ce que nous avons trouvé. Ce n'est pas une bonne façon de tester les idées. L'article parle aussi de la façon dont nous devrions utiliser de nouvelles données pour vérifier si nos idées sont correctes ou non. Au lieu de cela, les scientifiques utilisent souvent des statistiques compliquées pour valider leurs idées. Parfois, une analyse simple est meilleure qu'une analyse compliquée. Lorsque les scientifiques analysent les résultats de leurs expériences, ils effectuent souvent un rituel (comme suivre une recette pour faire un gâteau), où ils suivent les instructions sans vraiment réfléchir à ce qu'ils font. L'article suggère que nous devrions traiter les statistiques (la science de l'utilisation des données) comme une tool box, et choisir les bons outils en fonction de nos besoins. Nous devrions enseigner cela aux étudiants pour qu'ils puissent réfléchir attentivement et faire des choix intelligents. Parfois, un outil simple est le meilleur pour le travail. Enfin, l'article enseigne que nous ne devrions pas simplement suivre aveuglément les règles en statistique. Nous devons nous concentrer sur la taille de l'effet, faire une prédiction avant de réaliser une expérience, ne pas inventer d'histoires après une expérience, et ne pas suivre aveuglément les procédures standard, comme les tests d'hypothèse nulle. Nous devons choisir soigneusement la meilleure approche statistique pour le problème à l'étude. Pour apporter ces améliorations, les chercheurs doivent être courageux et remettre en question la façon dont les choses sont faites, même si cela pourrait contrarier certaines personnes."'

'Ce document de Gerd Gigerenzer parle des problèmes dans la façon dont nous utilisons les statistiques dans la recherche. Il dit que beaucoup de chercheurs ne prêtent pas assez attention à la taille de l'effet, qui nous indique la force d'un résultat expérimental. L'American Psychological Association (APA) suggère que cela devrait toujours être rapporté, mais souvent ce n'est pas le cas. Quand nous ne connaissons pas la taille de l'effet, il est impossible de calculer la puissance statistique d'une expérience. Une ancienne étude de 1962 a révélé que nous n'avons que 50% de chances de détecter un effet de taille moyenne dans une expérience de psychologie. Bien que beaucoup de personnes soient au courant de ce problème, cela n'a pas vraiment changé la façon dont les chercheurs font leur travail. Le célèbre scientifique Richard Feynman a critiqué la façon dont nous analysons souvent les résultats des expériences. Il a souligné que juste parce que nous trouvons quelque chose qui semble significatif et passe un test statistique, cela ne signifie pas grand-chose si nous n'avons pas fait une prédiction pour commencer. C'est simplement inventer une histoire après le fait. Gigerenzer met également en garde contre le "surajustement". C'est lorsque nous continuons à analyser les données jusqu'à ce que nous trouvions des résultats importants puis que nous inventons des histoires pour correspondre à ce que nous avons trouvé. Juste parce que nous pouvons faire correspondre nos modèles aux données existantes, cela ne signifie pas que nous testons très bien nos idées. Des procédures statistiques vraiment compliquées peuvent même faire correspondre du bruit aléatoire à notre modèle, donc parfois une analyse statistique simple est la meilleure. Mieux encore, tester un modèle existant sur de nouvelles données. Le document décrit comment les chercheurs mènent souvent une analyse statistique de leurs résultats expérimentaux comme s'ils effectuaient un rituel. Ils ne réfléchissent pas soigneusement à ce qu'ils font, ils suivent aveuglément une procédure. Ils sont impatients de trouver une petite p-value, qui détermine s'ils peuvent publier leurs résultats ou non. La plupart des scientifiques sont formés à croire qu'une petite p-value signifie qu'une expérience est "significative", mais même l'inventeur de la p-value a déconseillé cela. Le document suggère que nous devrions enseigner aux étudiants à considérer la théorie statistique comme une boîte à outils, où différents outils devraient être utilisés en fonction de la situation. Parfois, une analyse de données simple et claire n'est pas seulement suffisante, mais meilleure. Pour résoudre ce problème généralisé, les chercheurs doivent être courageux et défier les méthodes existantes, même si cela pourrait contrarier certaines personnes. En fin de compte, Gigerenzer conseille que nous ne devrions pas simplement suivre des rituels en statistique sans réfléchir. Au lieu de cela, nous devrions toujours rapporter les tailles d'effet, faire des prédictions avant de lancer des expériences, ne pas inventer des histoires pour correspondre aux données, et ne pas conduire aveuglément des tests d'hypothèse nulle. Il souligne que nous devrions utiliser une gamme plus large de procédures statistiques et sélectionner soigneusement celles qui sont appropriées pour chaque expérience. Gigerenzer appelle cela la "pensée statistique" et encourage plus de chercheurs à l'essayer.'

Let's start with the truth!

Support the Broken Science Initiative.

Subscribe today →

recent posts

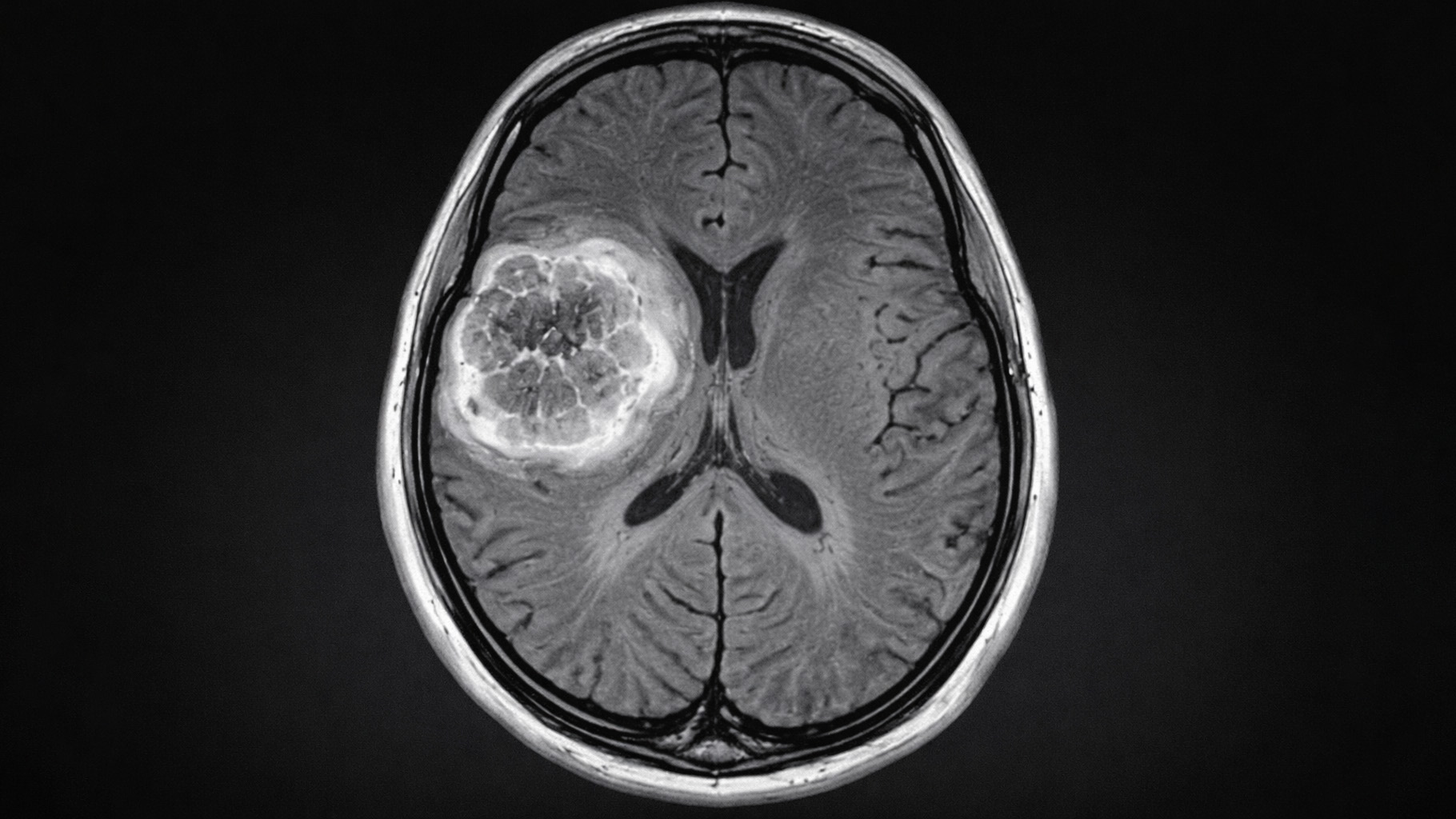

And more evidence that victory isn’t defined by survival or quality of life

The brain is built on fat—so why are we afraid to eat it?