'Ce commentaire éditorial de Gerd Gigerenzer et Julian Marewski discute le rêve d'une méthode universelle d'inférence en science. Le grand mathématicien Gottfried Wilhelm Leibniz a rêvé d'un calcul universel dans lequel toutes les idées pourraient être représentées par des symboles et discutées sans querelle. Il a prédit que le projet prendrait cinq ans, mais hélas, n'a jamais été terminé. À sa place, un substitut, la p-value, a été adoptée comme la méthode d'inférence préférée pour la recherche scientifique. Les critiques ont soutenu que les méthodes bayésiennes sont supérieures et devraient être le seul moyen d'analyse à l'avenir. Les auteurs de ce document soutiennent que les deux groupes ont tort de chercher le «faux idole» d'une méthode universelle d'inférence. Les p-values ont causé de grands dommages en remplaçant les répliques réelles par des inférences statistiques qui prétendent estimer la réplicabilité. De grands efforts pour effectuer des répliques d'études emblématiques ont montré que étonnamment peu se répliquent malgré de petites p-values. Les scientifiques d'Amgen n'ont pas pu reproduire 47 des 53 expériences qui ont fourni des cibles pour les médicaments potentiels révolutionnaires. Ceux-ci étaient considérés comme des études majeures et Amgen avait un intérêt financier à les faire fonctionner. Une autre analyse des répliques dans les journaux de gestion, de finance et de publicité a montré que 40 à 60% des répliques contredisaient les résultats des études originales. Les statisticiens ont mis en garde contre les p-values aussi longtemps qu'elles existent, mais elles sont toujours courantes. Un chercheur a calculé le nombre moyen de p-values signalées dans des articles publiés dans un journal d'affaires. C'était 99. Les auteurs ont même trouvé une p-value et un intervalle de confiance calculé pour le nombre de sujets dans une étude, comme s'il pouvait y avoir une incertitude à ce sujet! C'est simplement l'application insensée des statistiques rendue facile par des logiciels de statistiques conviviaux. Les bayésiens d'autre part étaient initialement prudents pour appliquer leurs méthodes uniquement à des situations de «petit monde» où l'incertitude est minimale. Plus tard, leur confiance dans la méthode a grandi et ils ont proposé un «bayésianisme universel» qui peut s'appliquer à des événements répétitifs statistiques ou à des événements singuliers. Les auteurs de cet article suggèrent que le théorème de Bayes peut être utile pour déterminer le risque, mais est d'une valeur incertaine dans un monde incertain. Les auteurs appellent l'utilisation automatique de la règle de Bayes en science un «belle idole», mais avertissent qu'il ne devrait être qu'un outil dans une plus grande boîte à outils. Un exemple de l'application réussie de Bayes en médecine est le calcul de la probabilité qu'une personne ait une maladie lorsqu'elle a été testée positive et que la prévalence de base de la maladie est connue. Sans un antécédent objectif, tel que la prévalence estimée de manière fiable d'une maladie, Bayes devient plus subjectif et moins fiable. Les auteurs ont trois points clés à faire dans ce commentaire: Il n'y a pas de méthode universelle d'inférence scientifique, mais plutôt une boîte à outils complète qui comprend des statistiques descriptives, une analyse exploratoire des données et des techniques de modélisation formelles. La seule chose qui ne devrait pas figurer dans la boîte à outils sont de fausses idoles. Si l'espéré «Révolution bayésienne» a lieu, une fausse idole pourrait être échangée contre une autre. Les facteurs de Bayes pourraient simplement remplacer les p-values comme niveau de signification automatiquement calculé de la science. Les méthodes d'analyse statistique utilisées en science modifient la science elle-même, et vice versa. Par exemple, alors que les sciences sociales mettaient de plus en plus l'accent sur les statistiques inférentielles, l'importance de la réplication et de l'erreur de mesure diminuait. Les percées scientifiques passées, telles que celles d'Isaac Newton et de Charles Darwin, n'ont fait aucune utilisation d'inférence statistique. Newton a mené des expériences soigneuses pour démontrer les effets prédits par ses théories. Aucune statistique n'a été rapportée, même s'il connaissait les méthodes statistiques et les employait même pour le contrôle de qualité dans son métier de maître de la Monnaie royale de Londres. Dans le domaine de la psychologie, maintenant dominé par les statistiques inférentielles, des percées antérieures de Piaget, Pavlov, Skinner et d'autres n'ont fait aucune utilisation d'elles non plus. Ni l'inférence statistique ni bayésienne n'a joué de rôle majeur en science jusqu'aux années 1940. Peu de temps après, le «Rituel Nul» est devenu la méthode d'inférence prédominante, en particulier dans les sciences sociales. Il se compose de trois étapes: Établissez une hypothèse nulle (aucune différence moyenne ou corrélation zéro) sans énoncer votre propre hypothèse. Utilisez 5% comme convention pour rejeter le nul. Effectuez toujours cette procédure. Ce rituel est devenu codifié dans les manuels de publication scientifique, qui ont déterminé le style et la substance de la recherche publiée. Le rituel nul est un hybride du travail de Ronald Fisher et Neyman/Pearson, bien qu'il viole les recommandations des deux. Fisher a une fois proposé le seuil de 5% comme une convention, mais a plus tard désavoué cette pratique. Il a conseillé que les chercheurs devraient: établir une hypothèse nulle qui n'est pas nécessairement une hypothèse nulle. Signalez le niveau exact de signification trouvé. Utilisez cette procédure uniquement si peu de choses sont connues sur le problème étudié. Les auteurs concluent leur éditorial par l'aveu sombre d'un avantage du rituel nul: une source constante d'emploi.''pour des scientifiques moyens qui continueront à publier des recherches non créatives avec peu d'innovation ou de risque.'

'Un grand rêve des scientifiques est d'avoir un jour un moyen d'analyser toute recherche et de déterminer facilement si elle est une connaissance fiable ou non. Cependant, personne n'a jamais accompli cet objectif, mais beaucoup de scientifiques ont agi comme s'ils avaient une méthode universelle. Leur méthode privilégiée est appelée un p-value. Il est considéré qu'un petit p-value signifie qu'il est plus de 95% probable que le résultat qu'ils trouvent dans une expérience se produira à nouveau s'ils répètent l'expérience. Cependant, lorsque les scientifiques refont les expériences d'autres scientifiques, ils n'obtiennent pas le même résultat plus de la moitié du temps. Cela signifie qu'une grande partie des connaissances scientifiques n'est pas aussi précise que nous le pensions. Une grande partie du problème est que les scientifiques ont des logiciels qui facilitent la recherche d'un p-value pour toutes les données qu'ils insèrent dans leurs logiciels. Ces scientifiques ne sont pas conscients que d'autres méthodes pourraient être meilleures pour le type de recherche qu'ils analysent. Au lieu de cela, ils suivent ce que les auteurs de cet éditorial appellent le null ritual. Le null ritual est quand les données sont comparées à une hypothèse nulle arbitraire (l'attente d'aucun effet ou corrélation). Si les données obtiennent un petit p-value, alors l'hypothèse nulle est rejetée en faveur de l'hypothèse du chercheur (l'attente de l'idée du chercheur étant testée). Et la dernière partie du rituel est de toujours exécuter cette procédure. D'autres chercheurs ont promu une méthode appelée Bayes' theorem, qu'ils pensent être la seule façon d'analyser la recherche. Il y a quelques applications vraiment efficaces de Bayes, comme déterminer si quelqu'un est vraiment malade lorsqu'il a été testé positif pour une maladie. Si c'est une maladie rare, il y a de bonnes chances que le patient soit bien et que le test était faux (un faux positif dans ce cas). Les auteurs de cet article conseillent que les scientifiques devraient se familiariser avec une plus grande variété de méthodes statistiques et utiliser chaque outil de cette boîte à outils quand il est le bon pour le travail à accomplir. Jusque-là, les scientifiques continueront à produire des tonnes de recherches de qualité moyenne.'

'Dans les années 1600, un célèbre mathématicien nommé Gottfried Wilhelm Leibniz a proposé une recherche pour une méthode universelle d'analyse de l'information. Il pensait qu'il ne faudrait que cinq ans, mais ce projet n'a jamais été achevé. Cependant, de nombreux scientifiques agissent comme s'ils avaient une méthode universelle et l'appliquent à chaque problème de recherche qu'ils peuvent. La méthode d'analyse statistique la plus courante en science, en particulier dans les sciences sociales comme la psychologie, le management et la finance, est appelée une p-value. La plupart des scientifiques pensent qu'une petite p-value signifie qu'il y a une forte probabilité (plus de 95%) que leurs résultats de recherche se reproduisent si leur expérience est répétée. Cependant, de nombreux projets de réplication à grande échelle ont montré que plus de la moitié de la science publiée ne se reproduit pas. Une grande entreprise de biotechnologie appelée Amgen n'a pas réussi à reproduire 47 des 53 grandes études académiques qui avaient proposé de nouveaux traitements médicamenteux possibles pour le cancer. Beaucoup de temps et d'argent ont été gaspillés à poursuivre des recherches basées sur une science peu fiable. Les auteurs de ce document écrivent que les scientifiques suivent aveuglément un "rituel null" lorsqu'il s'agit d'interpréter les résultats de leurs expériences. D'abord, ils comparent leurs résultats à une hypothèse nulle. Le null est une attente de corrélation ou d'effet nul. Deuxièmement, ils fixent un seuil arbitraire de 5% pour déterminer si leurs conclusions sont significatives. Si ce seuil est franchi, ils rejettent l'hypothèse nulle en faveur de leur propre hypothèse. Et troisièmement, ils répètent ce processus dans chaque expérience. Ce rituel a été enseigné dans les manuels de statistique pour les psychologues et les scientifiques sociaux et est requis par de nombreux éditeurs. Même l'inventeur du test d'hypothèse, Ronald Fisher, déconseille cette procédure. Il dit qu'un seuil de significativité devrait être différent pour chaque projet de recherche. Une hypothèse nulle ne doit pas toujours être une corrélation zéro. Et cette procédure ne doit pas être faite tout le temps. De grands scientifiques du passé, comme Isaac Newton et Charles Darwin, n'ont jamais utilisé de p-values ni aucun type de statistique inférentielle. La plupart des percées en science jusqu'aux années 1940, y compris les sciences sociales, n'ont pas rapporté de p-values ni d'intervalle de confiance ni aucune des statistiques que l'on voit partout aujourd'hui. Au lieu de cela, de grands scientifiques comme Newton, Pavlov et Skinner ont mené des expériences pour démontrer les effets prédits par leurs théories. Les auteurs de ce document déconseillent la recherche d'une méthode universelle d'analyse. Ils l'appellent une "fausse idole". Cela inclut une méthode populaire appelée le théorème de Bayes. Il peut être très utile dans certaines situations où il y a peu d'incertitude, mais il ne devrait pas être appliqué automatiquement dans toutes les situations. Un exemple de où il est utile est dans le diagnostic médical. Si une personne a été testée positive pour une maladie, il n'est pas nécessairement vrai que la personne a réellement la maladie, même si le test est très fiable. Si la maladie est rare dans la population, alors il y a de fortes chances que la plupart des personnes qui sont testées positives n'aient pas réellement la maladie. Dans ce cas, les faux positifs sont plus courants que les vrais positifs. Les auteurs concluent que les scientifiques ont besoin d'apprendre une grande variété de méthodes statistiques et de savoir quand chacune est l'outil approprié pour le travail. Sinon, les scientifiques continueront de produire des recherches de qualité moyenne et qui échouent souvent à se reproduire.'

Let's start with the truth!

Support the Broken Science Initiative.

Subscribe today →

recent posts

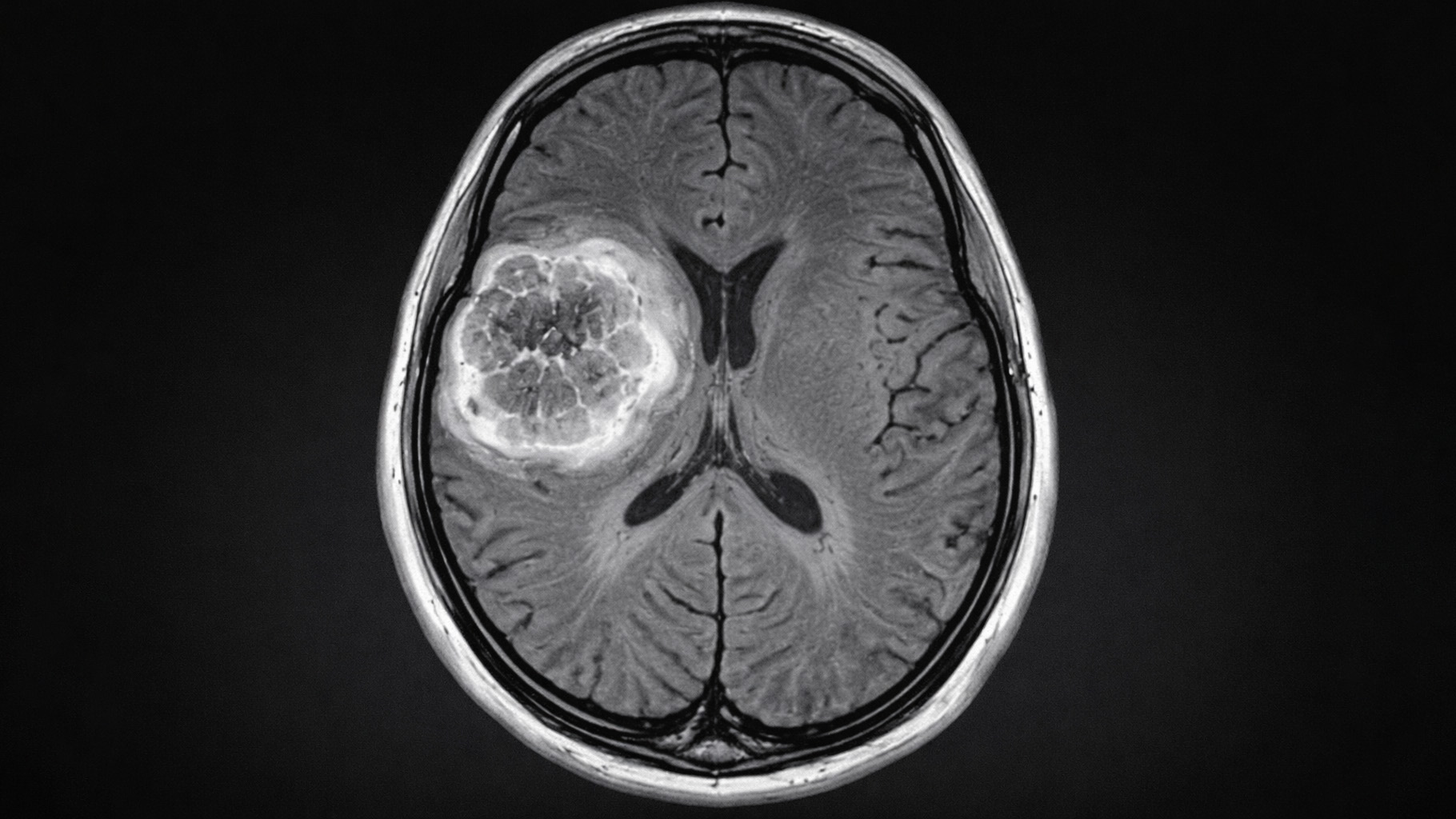

And more evidence that victory isn’t defined by survival or quality of life

The brain is built on fat—so why are we afraid to eat it?

Q&A session with MetFix Head of Education Pete Shaw and Academy staff Karl Steadman