-

link to PDF

- Kevin Knuth

Choose a reading level from the dropdown above.

'La presentación de Kevin Knuth sobre la historia de la teoría de la probabilidad comienza con la famosa cita de Laplace, que dice que "la teoría de la probabilidad es básicamente el sentido común reducido a cálculo". La lógica tradicional solo se preocupa por lo que es absolutamente verdadero o falso. El científico James Clerk Maxwell abogaba que la probabilidad se refiere a la magnitud de la verdad que existe entre los extremos de verdadero y falso. La probabilidad se presenta comúnmente como P(x|y), que se traduce en la probabilidad de que x sea verdadera dado que y es verdadera. Knuth presenta la visión de John Maynard Keynes de que la probabilidad debe interpretarse como un grado de verdad o el grado de creencia que una persona racional tendría en una hipótesis. Es en cierto sentido subjetiva, pero no debido a la influencia de la "capricho del hombre". Una tercera visión de la probabilidad la explica como un "grado de implicación". A Knuth le gusta esta interpretación. Se explican tres sistemas fundamentales de la teoría de la probabilidad: el método de Bruno De Finetti calculaba las probabilidades como un grado de creencia cuantificado por cuánto una persona racional apostaría a un resultado previsto. El énfasis está en la consistencia. Knuth lamenta que esta es la base más comúnmente presentada. Anton Kolmogorov creó axiomas fundamentales de la teoría de la probabilidad que son especialmente populares entre los bayesianos modernos. Con estos axiomas, las probabilidades se pueden calcular algebraicamente. Richard Cox generalizó la lógica booleana a grados de creencia racional. Sus axiomas permitieron el cálculo de las probabilidades de múltiples eventos e incluyeron la relación entre las proposiciones y sus contradictorias. De Finetti y Kolmogorov crearon sistemas que eran completos y autónomos. La creación de Cox fue suficientemente correcta para ser útil, lo suficientemente interesante para ser convincente y dejó suficiente espacio para la mejora futura. Mucho de este trabajo fue hecho por E.T. Jaynes. Knuth luego presenta una perspectiva moderna sobre la probabilidad. Se ocupa principalmente de determinar qué tipos de conocimiento pueden describirse con ecuaciones: las leyes del universo y las restricciones impuestas por el orden subyacente son ejemplos claros. Introduce lattices como una herramienta para entender la probabilidad. Estos son conjuntos parcialmente ordenados de elementos con un límite superior mínimo y un límite inferior máximo (conceptualmente un techo y un suelo). La cuantificación y las operaciones lógicas se pueden realizar en lattices mientras se preserva el orden de su estructura. Knuth demuestra cómo la asociatividad de las operaciones lógicas (instancias en las que el orden de las operaciones lógicas no importa) puede usarse para derivar los fundamentos de la teoría de la medida. Muestra cómo funciona la aditividad de las operaciones lógicas y da lugar a la regla de la suma omnipresente. También se demuestra la inferencia, comenzando con un ejemplo de lo que podemos saber sobre el contenido de una cesta de la compra. Aprendemos que se puede inferir conocimientos de nivel superior a partir de la estructura de un lattice. Incluso deriva el teorema de Bayes a partir de operaciones matemáticas realizadas en un lattice. La lógica y las matemáticas se pueden usar para calcular las probabilidades dentro de un lattice en aplicaciones tan variadas como las cestas de la compra y la física cuántica. Knuth concluye que los fundamentos de la probabilidad actúan como una base amplia a partir de la cual se pueden hacer teorías novedosas en dominios aparentemente dispares.'

'La probabilidad se trata de averiguar cuán probable es que algo ocurra. No es simplemente verdadero o falso. Hay un rango completo en medio. Los expertos han debatido el significado de la probabilidad y algunos piensan que significa cuánto es verdadera una idea o cuán fuertemente una persona debería creer en una idea. El autor de esta presentación, Kevin Kneuth, cree que la probabilidad debería ser cuán fuertemente se implica una idea. Se escribe una probabilidad así: P(x|y). Significa "¿Cuán probable es x si y es verdadero?". Tres de los mayores expertos en probabilidad presentaron diferentes ideas sobre cómo debería funcionar: Bruno de Finetti explicó la probabilidad por cuánto apostarías a que algo suceda. La consistencia es clave. Anton Kolmogorov creó reglas matemáticas para calcular probabilidades, como en álgebra. Richard Cox utilizó la lógica y las matemáticas para decidir cuán probable es que una idea sea verdadera. Su trabajo fue genial y la gente lo mejoró aún más más tarde. Una visión moderna de la probabilidad examina qué tipos de ideas pueden describirse con ecuaciones matemáticas. Las reglas de la naturaleza y el orden son ejemplos mayores. Una herramienta para hacer matemáticas de probabilidad es un lattice: conjuntos ordenados con límites superiores e inferiores. Su estructura te permite idear nuevas ideas sobre los ítems en un lattice. También puedes hacer operaciones matemáticas sobre ellos bajo unas pocas reglas básicas como: El orden de algunas operaciones no importa. La suma funciona como se espera. Puedes crear conocimiento de nivel superior (llamado inferencia). Estas reglas te permiten calcular probabilidades. Incluso el teorema de Bayes puede derivarse de esta manera. Los principios funcionan ampliamente, desde las listas de comestibles hasta la física cuántica. En resumen, las bases de la teoría de la probabilidad proporcionan una base para nuevas teorías en muchas áreas. Las reglas de las matemáticas y la lógica pueden ayudar a calcular las probabilidades.'

'La teoría de la probabilidad se trata de calcular cuán probable es que algo suceda. En el pasado, la lógica solo trataba con lo que es absolutamente verdadero o falso. Pero los científicos se dieron cuenta de que hay un rango completo de posibilidades entre esos extremos. La probabilidad a menudo se escribe como P(x|y). Esto significa "la probabilidad de que x sea verdadero, asumiendo que y es verdadero". Hay algunas formas de pensar sobre lo que realmente significa la probabilidad: El grado en que una idea es verdadera. Cuán fuertemente una persona racional debería creer en una idea. Cuán fuertemente se implica que una idea es verdadera o falsa. El escritor de esta presentación, Kevin Knuth, prefiere la tercera interpretación. A continuación, introduce a tres fundadores clave que desarrollaron sistemas de teoría de la probabilidad: Bruno de Finetti se centró en cuánto apostaría una persona a que un cierto resultado fuera verdadero. La coherencia era clave. Anton Kolmogorov creó reglas matemáticas para calcular probabilidades. Richard Cox generalizó la lógica para manejar grados de creencia. Su trabajo fue crítico, pero aún dejó espacio para mejorar. E.T. Jaynes y otros construyeron sobre sus ideas. Una visión moderna examina qué tipos de conocimiento pueden ser descritos por ecuaciones de probabilidad. Las reglas de la naturaleza y el orden en el mundo son ejemplos principales. Una herramienta utilizada para entender las probabilidades se llama un lattice - conjuntos ordenados con límites superiores e inferiores. Puedes hacer matemáticas y operaciones lógicas en ellos de una manera que preserve su orden. Esto lleva a las reglas básicas de probabilidad: Asociatividad - el orden de algunas operaciones lógicas no importa. Aditividad - las sumas funcionan como se espera. Inferencia - el conocimiento de nivel superior se puede derivar de la estructura de un lattice. Estas reglas permiten calcular las probabilidades. Incluso el teorema de Bayes se puede derivar de estas reglas. Los principios se aplican ampliamente, desde las listas de la compra hasta la física cuántica. En resumen, los fundamentos de la teoría de la probabilidad actúan como base para nuevas teorías en muchos campos. La coherencia, las reglas de las matemáticas y la lógica, y la inferencia contribuyen a calcular la probabilidad de las ideas.'

Let's start with the truth!

Support the Broken Science Initiative.

Subscribe today →

recent posts

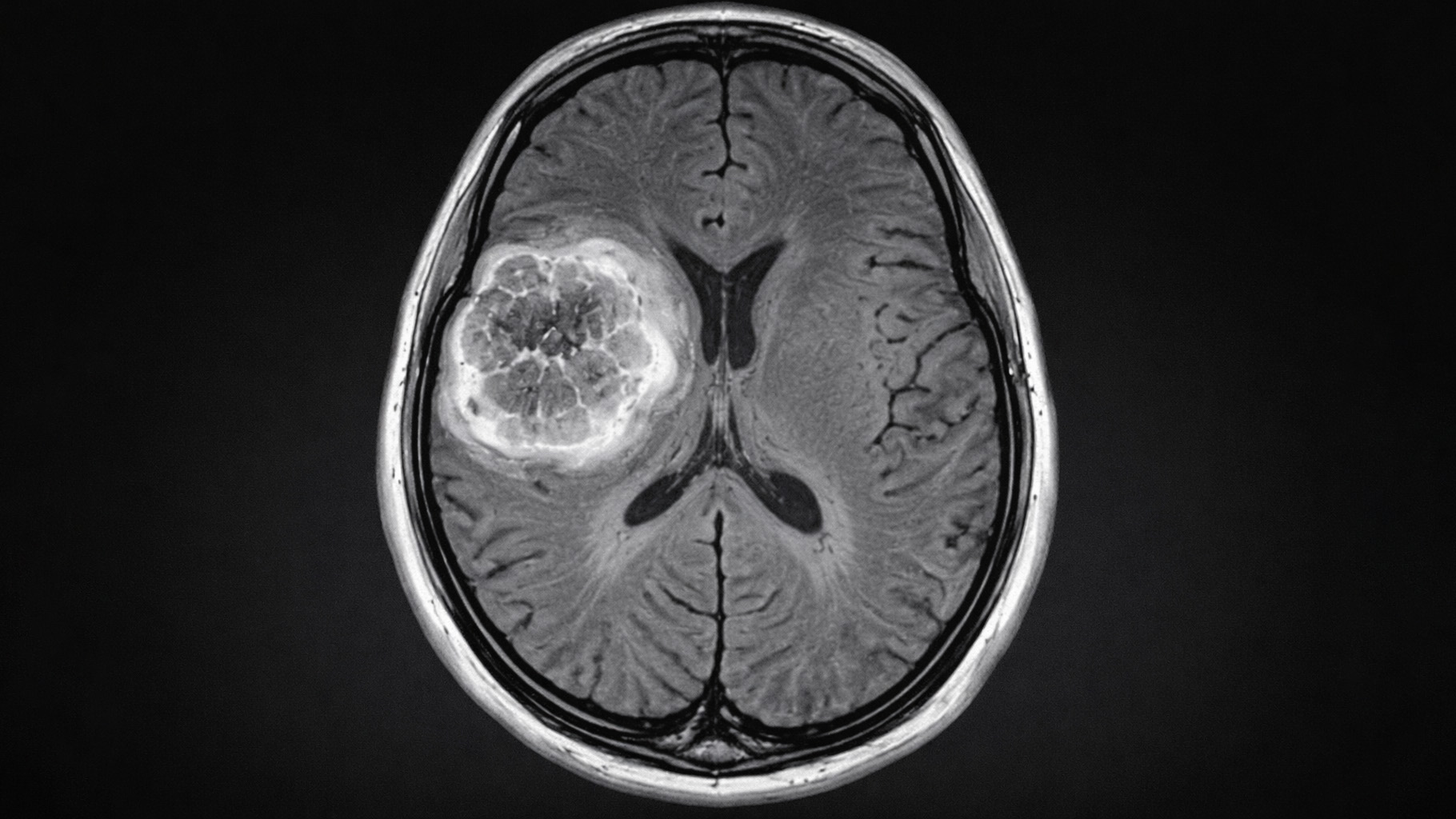

And more evidence that victory isn’t defined by survival or quality of life

The brain is built on fat—so why are we afraid to eat it?