Choose a reading level from the dropdown above.

'I teorici della probabilità sono principalmente divisi in due campi. Entrambi si occupano di frequenze all'interno di un framework predittivo e aspettative ragionevoli. Ma ogni lato dà la priorità all'uno rispetto all'altro come concetto primario di probabilità. L'interpretazione della frequenza è più popolare, ma l'autore di questo articolo, Richard Cox, crede che questo sia un errore. Fornisce l'esempio di una box contenente due palline bianche e una nera, identiche tranne che per il colore. Quindi spiega come ciascun gruppo interpretirebbe questa situazione. L'interpretazione frequentista valuterebbe la probabilità di pescare una palla bianca come ⅔. Risolvono il problema immaginando di estrarre una palla da un numero indefinito di box; o estraendo ripetutamente una palla da una box e poi sostituendola. In entrambi i casi, su un numero enorme di ripetizioni, la frequenza di una palla bianca estratta convergerebbe a ⅔. Secondo loro, questo non è una previsione della teoria delle probabilità, ma una definizione di probabilità. La probabilità è una caratteristica dell'"ensemble" (setup di test) e non esiste senza di esso. Nella seconda interpretazione, la teoria delle probabilità fornisce l'aspettativa ragionevole di estrarre una palla bianca due terzi del tempo e una palla nera un terzo del tempo. Questa misura di aspettativa ragionevole è il significato principale della probabilità secondo il secondo gruppo. Le due interpretazioni della probabilità hanno molto in comune. Entrambi i metodi possono calcolare algebricamente la probabilità che un evento si verifichi o meno, che uno o un altro evento si verifichi, o che entrambi gli eventi si verifichino. Ciascuno specifica anche che se un evento è improbabile che si verifichi, allora è più probabile che non si verifichi. Allo stesso modo, la probabilità che due eventi si verifichino insieme è inferiore alla probabilità del meno probabile dei due. Se le frequenze e le aspettative ragionevoli fossero perfettamente interscambiabili, allora la divisione tra i teorici della probabilità sarebbe puramente grammaticale. Tuttavia, ci sono differenze importanti. In alcuni casi, è impossibile immaginare un ensemble che potrebbe testare ripetutamente la frequenza di un evento. Ma ci sono casi in cui una probabilità non può essere determinata da un ensemble. Ad esempio, c'è un concetto nella scienza secondo cui un'ipotesi semplice è preferibile a una complessa. Due o più postulati che sono veri sono meno probabili di un singolo postulato della stessa probabilità che sia vero. Questa preferenza è una credenza ragionevole, ma non ha una frequenza testabile. Cox sostiene che la debolezza dell'interpretazione frequentista è che ci sono così tante situazioni in cui un ensemble definibile non esiste. Le regole che sono state derivate dal test delle frequenze all'interno degli ensemble non possono essere giustificate nell'uso al di fuori di questo dominio. John Maynard Keynes ha sviluppato una teoria originale della probabilità che non dipende dalla frequenza. Per Keynes, la teoria della probabilità è una forma di logica che si applica alle inferenze probabili. La probabilità è quindi il grado di credenza razionale corrispondente a un'ipotesi e alla sua conclusione. La probabilità esclude la certezza assoluta e l'impossibilità (il dominio della logica deduttiva), ma riguarda i valori tra questi estremi. La definizione di frequenza dell'incertezza è invalida perché tratta la probabilità come una proprietà di un oggetto che ha un certo valore, come la distanza o il tempo in meccanica. Mentre Cox è d'accordo con le vedute di Keynes sulle probabilità, sentiva che c'era ancora lavoro da fare per definire i suoi assiomi fondamentali. Molte delle postulazioni della teoria della probabilità keynesiana provengono dallo studio dei giochi d'azzardo (lanci di monete, dadi, giochi di carte) e portano i "segni di strumento" di questa origine. L'obiettivo di Cox era derivare gli assiomi fondamentali della probabilità indipendentemente da qualsiasi ensemble. Per fare ciò, Cox delinea i fondamenti della logica simbolica e fornisce undici assiomi fondamentali. Di questi, sei sono fondamentali e i restanti cinque possono essere derivati dai precedenti. Questi assiomi forniscono le regole di base con cui le manipolazioni algebriche possono essere eseguite su espressioni di probabilità logica, che definisce successivamente. Utilizza i simboli b|a per descrivere la probabilità di b se a viene accettato come vero. Riformula questo come "la credibilità di b sull'ipotesi a". Le formule matematiche possono essere utilizzate per operare su espressioni di probabilità in questa forma. Cox ne dimostra diverse, tra cui la moltiplicazione e le esponenziali. L'ipotesi più importante di questa sezione è che la probabilità di c e b dato a (c·b|a) è uguale alla probabilità di c dato b e a e anche b dato a (c·b|a = c|b·a , b|a). Cox spiega questo con un esempio di probabilità che un corridore può correre una certa distanza e tornare indietro su un certo tracciato senza fermarsi. Il valore a è quello che sappiamo sulle condizioni fisiche del corridore e del tracciato. Il valore b è la prova che ha percorso una certa distanza senza fermarsi. Il valore c è che lui''è tornato da quella distanza senza fermarsi. La probabilità che il corridore possa correre la prima tappa senza fermarsi dato quello che sappiamo da a è: b|a. La probabilità che il corridore ritorni senza fermarsi dato che la prima tappa è stata completata e anche dato quello che sappiamo da a è: (c|b·a). Così, la probabilità che il corridore possa correre una certa distanza e ritornare (c·b|a) è una funzione delle prime due probabilità. Una seconda supposizione riguarda la probabilità di b e non-b dato a. Il simbolo, ~b, è usato per significare "non b" nel senso che se b significa "l'auto è bianca", allora ~b significa "l'auto non è bianca". Il simbolo ~ non implica la contraddizione, che sarebbe "l'auto è nera". Una formula importante da conoscere da questa sezione è che la probabilità di b|a + ~b|a = 1. In altre parole, la somma delle probabilità per b dato a e non-b dato a è 1 (un p value di 1 significa certezza completa). La prima parte di questo paper ha sostenuto che la probabilità ha un ambito più ampio rispetto a quello che implica la definizione di frequenza. La seconda parte ha derivato le regole di base della probabilità dagli assiomi fondamentali. La terza parte dell'essay spiega come questa nuova comprensione della probabilità gestisce la frequenza di un evento. Cox dà l'esempio di due campioni di radon. Uno è più vecchio dell'altro, ma non sono etichettati. Ciascuno è collegato a un contatore di ioni identico e l'obiettivo è prevedere quale campione raggiungerà per primo 1000 conteggi di ioni. Un fisico con conoscenza della meccanica quantistica stimerebbe che i due campioni hanno la stessa probabilità di raggiungere per primo 1000 conteggi. Una persona comune senza conoscenze deriverebbe la stessa probabilità, ma per ignoranza. La stima del fisico è chiamata probabilità oggettiva. La stima del non fisico viene comunemente chiamata probabilità soggettiva, anche se Cox preferisce il termine "probabilità primaria". Questo termine descrive meglio una situazione in cui non si sa nulla sul problema. Cox descrive poi una situazione in cui un dado viene lanciato molte volte e può o non può avere due lati con quattro punti. La frequenza di tirare un quattro dovrebbe essere o 1 su 6 o 1 su 3. In questo caso, una probabilità stabile non può mai essere raggiunta, ma può essere stimata. Cox poi deriva che una stima diventa "più precisa" più prove sono state condotte. Anche se Cox non usa il termine, questo è spesso chiamato "the Law of Large Numbers". Poi affronta un'ipotesi di Laplace, che una probabilità sconosciuta ha la stessa probabilità di avere qualsiasi valore tra 0 e 1. Quest'ipotesi è generalmente vera, tranne nei casi in cui il p value è 0 o 1, o quando il numero di prove è molto piccolo. Cox dimostra che Laplace aveva ragione, ma con meno generalità di quanto supponesse Laplace. Sotto l'interpretazione di aspettativa ragionevole di Cox della probabilità, la frequenza di un evento si avvicina a una probabilità stabile man mano che il numero di istanze aumenta e conclude: "questo è tutto ciò che dovremmo aspettarci". Una "vera" frequenza non può mai essere raggiunta, poiché un numero infinito di esperimenti non può essere eseguito.'

'La probabilità misura quanto sappiamo su una situazione incerta. Esistono due principali modi di pensare a questo. Un modo è guardare quanto spesso accade qualcosa se ripeti un esperimento molte volte. L'altro modo è pensare a quanto sia ragionevole aspettarsi che qualcosa accada in base a quello che sai. La maggior parte degli scienziati crede che il primo modo sia corretto, chiamato "frequentismo", ma questo articolo di Richard Cox sostiene che il secondo modo è migliore. Per mostrare come ogni opinione sia diversa, l'autore ha utilizzato un esempio di estrazione di una palla da una box con una palla bianca e due palle nere. Il primo modo direbbe che se hai estratto una palla da questa box molte volte, otterresti una palla bianca una volta su tre e quella frequenza di ⅓ è la probabilità. Il secondo modo direbbe che è ragionevole aspettarsi una palla bianca una volta su tre. Anche se puoi scegliere solo una palla una volta, è comunque ragionevole giudicare questa come la probabilità. Questi due modi concordano per lo più su come calcolare le probabilità. Ma ci sono alcuni casi in cui il primo metodo non funziona perché non puoi ripetere un esperimento infinite volte. Un filosofo di nome John Maynard Keynes ha creato un sistema per calcolare la probabilità basato sulla logica (utilizzando regole per fare giudizi) invece degli esperimenti ripetuti. L'autore di questo articolo voleva elaborare delle regole di base della probabilità per il sistema di Keynes. Ha utilizzato simboli della matematica e della logica per mostrare le probabilità. Un esempio è "b|a" che significa "la probabilità di b se a è vero". Mostra come puoi combinare le probabilità utilizzando la matematica, come ad esempio sommandole. Cox parla anche di come, ripetendo più volte un esperimento, ottieni un'idea migliore della probabilità. Mostra come il filosofo Laplace avesse ragione su questo, ma ha fatto alcune ipotesi che non erano del tutto corrette. Alla fine, Cox dice che puoi avvicinarti alla vera probabilità di qualcosa solo misurandone la frequenza. Ma ci sono molte altre volte in cui non puoi misurare una frequenza, ma puoi comunque fare una stima ragionevole.'

'La teoria della probabilità si divide in due prospettive principali. Una è l'interpretazione di frequenza, che esamina il tasso in cui qualcosa si verifica quando si ripete un esperimento. L'altra è la visione dell'aspettativa ragionevole, che considera quanto è probabile qualcosa basandosi su ciò che si sa. L'autore di questo paper è Richard Cox, un fisico americano. Egli sostiene che l'interpretazione della frequenza è sbagliata e propone l'interpretazione dell'aspettativa ragionevole della probabilità. L'articolo fornisce l'esempio di estrarre una pallina bianca da una box contenente una pallina bianca e due palline nere. Se si preleva una pallina dalla box molte volte, si sceglierà una pallina bianca 1 volta su 3. Quindi, il lato della frequenza direbbe che la probabilità di scegliere una pallina bianca è ⅓. La visione dell'aspettativa ragionevole direbbe che è sensato aspettarsi di estrarre una pallina bianca 1/3 del tempo perché ⅓ delle palline sono bianche. Queste prospettive calcolano spesso le probabilità in modo simile. Ma ci sono alcune idee che hanno una probabilità, ma non possono essere testate con esperimenti ripetuti. Il filosofo John Maynard Keynes vedeva la probabilità come qualcosa che poteva essere espressa usando la logica (regole di come le idee si riferiscono l'una all'altra). L'autore di questo paper voleva creare regole base della probabilità, chiamate assiomi, per andare con la filosofia di Keynes. Ha dimostrato che ci sono 11 assiomi fondamentali e sei di essi possono essere creati dai primi cinque. Ha anche insegnato come simboli come "b|a" possono essere usati per significare "probabilità di b se a è vero". Poi ha dimostrato come quei simboli che rappresentano le probabilità potrebbero essere manipolati con operazioni matematiche. Cox ha anche esaminato un'idea, a volte chiamata "the Law of Large Numbers", che dice come una stima della probabilità diventa più accurata dopo che un esperimento è stato ripetuto molte volte. Ha mostrato che il filosofo Laplace aveva ragione su questo, ma ha fatto alcune ipotesi errate. Alla fine, Cox afferma che una stima della probabilità di qualcosa diventa più stabile dopo molte misurazioni, ma questo è il massimo che si può dire. Quindi, l'interpretazione di frequenza della probabilità non può mai raggiungere una vera frequenza di probabilità perché non si può mai eseguire un numero infinito di esperimenti. E ci sono molte volte in cui non si può nemmeno eseguire più esperimenti, quindi l'interpretazione delle aspettative ragionevoli ha più senso in più situazioni.'

Let's start with the truth!

Support the Broken Science Initiative.

Subscribe today →

recent posts

How a Low-Carb Ketogenic Diet Naturally Activates the Same Pathways

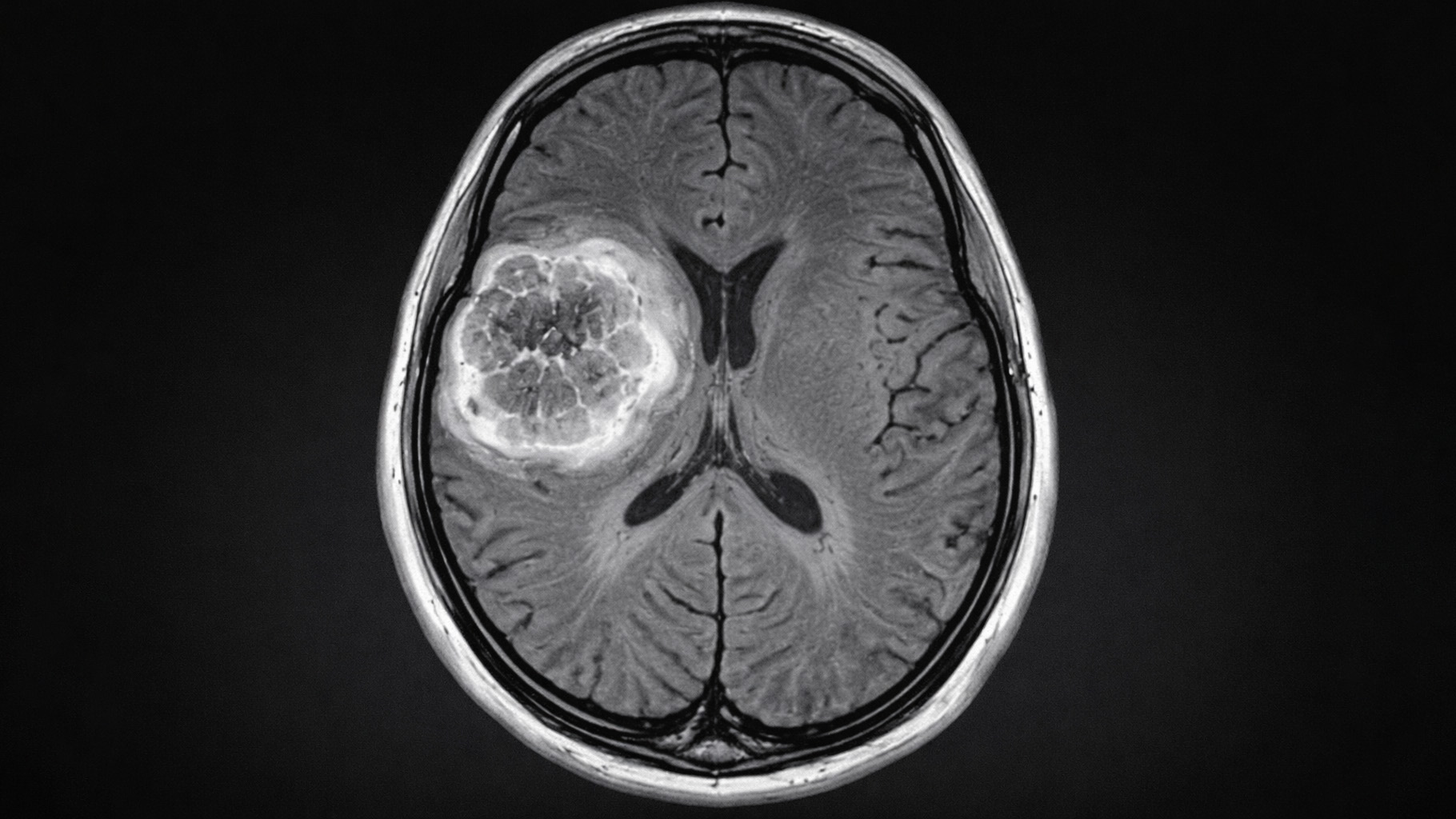

And more evidence that victory isn’t defined by survival or quality of life